물리학에서 엔트로피는 어떠한 물리계의 무질서한 정도를 의미한다. 정보이론에서도 엔트로피는 무질서한 정도를 뜻하며, 더욱 엄밀히 말하자면 "불확실성"을 의미한다. 아래의 [그림 1-a]는 엔트로피가 낮은 데이터이고, [그림 1-b]는 엔트로피가 높은 데이터이다.

[그림 1] 데이터와 엔트로피

위의 [그림 1-a]의 데이터에서는 모든 영역이 검은색이므로 불확실성이 낮다. 즉, 데이터 중에 어떤 부분을 선택하더라도 검은색이 추출된다는 것을 확실하게 말할 수 있다. 그러나 [그림 1-b]의 데이터에서는 흰색과 검은색이 무작위하게 분포되어 있기 때문에 불확실성이 높다.

위의 [그림 1-a]와 같은 데이터를 표현할 때는 검은색을 표현하는 단 하나의 비트 1만 있으면 충분할 것이다. 그러나 [그림 1-b]와 같은 데이터를 표현하기 위해서는 001010110101101010011101101010010110과 같이 총 36개의 비트가 필요하다. 이와 같이 정보이론에서 엔트로피가 높다는 것은 정보의 양이 많다는 것을 의미한다.

정보이론에서는 엔트로피를 확률적으로 정의한다. 먼저, 엔트로피를 정의하기 위해 전체 데이터에서 어떠한 기호가 등장할 확률 (symbol probability)을 [식 1]과 같이 정의한다. 아래의 [식 1]에서 ${m}_{i}$는 데이터에서 어떠한 기호 ${s}_{i}$가 등장하는 횟수이며, $L$은 데이터의 길이이다.

어떠한 기호의 정보량은 아래의 [식 2]와 같이 정의된다. 로그 함수의 정의에 따라 정보량은 ${P}_{i}$가 작아질수록 커지며, ${P}_{i}$가 1에 가까울수록 0으로 수렴한다. 어떠한 기호가 나타날 확률이 아주 낮다면, 이 기호가 나타난다는 것을 알기 위해서는 많은 정보가 필요할 것이다. 그러나 어떠한 기호가 나타날 확률이 1에 수렴한다면, 적은 양의 정보만으로도 기호가 나타날 것을 쉽게 유추해낼 수 있을 것이다.

마지막으로, 엔트로피는 아래의 [식 3]과 같이 정의된다.

위의 [식 3]의 정의와 같이 엔트로피는 정보량의 기댓값이라고 생각할 수 있다. 즉, 정보이론에서 엔트로피는 어떠한 데이터를 표현하기 위한 평균 정보량을 의미한다. 또한, [식 3]에서 알 수 있듯이 엔트로피는 각각의 기호가 등장할 확률이 비슷해질수록 증가하며, 각각의 기호가 등장할 확률이 모두 동일할 때 가장 크다. 이러한 현상은 전체 데이터에서 흰색과 검은색이 나타날 확률이 비슷한 [그림 1-b]의 엔트로피가 검은색만 존재하는 [그림 1-a]의 엔트로피보다 왜 높은지를 알려준다.

'IT' 카테고리의 다른 글

| 머신 러닝 기반의 Scientific Application을 위한 파이썬 라이브러리 (0) | 2020.05.21 |

|---|---|

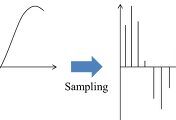

| 샘플링 (Sampling), 양자화 (Quantization) 및 부호화 (Coding) (0) | 2016.10.24 |

| Java에서 문자열을 XML 파일로 변환하기 (0) | 2016.02.19 |

| 공공데이터를 이용한 어플리케이션 개발 (0) | 2016.02.17 |

| Android Studio에서 RenderScript 환경 구축 (0) | 2016.02.02 |