강화 학습은 주로 Markov decision process (MDP)라는 확률 모델로 표현된다. MDP는 의사결정 과정을 확률과 그래프를 이용하여 모델링한 것으로써, "시간

이 글에서는 MDP에 대해 설명하기 전에 MDP의 기본 모델이 되는 Markov reward process에 대해 먼저 서술한다.

Markov reward process는 Markov process의 각 state에 reward를 추가하여 확장한 것이다. Markov reward process는 아래와 같이 정의된 <

예를 들어, 아래의 [그림 1]과 같이 유적을 탐험하는 모험가의 상황은 Markov decision process로 표현될 수 있다. 이때 [그림 1]에서 각 원은 state, 화살표에 부여된 값은 transition probability,

유적은 Room 1~3과 보물이 있는 Treasure, 함정에 해당하는 Trap, 그리고 유적 외부를 뜻하는 Outside으로 구성되어 있다. 각각의 공간에서는 확률적으로 다음 공간으로 이동할 수 있으며, 각 공간에 도착할 때마다 특정 reward를 획득하게 된다. Outside 또는 Trap에 도착하게 되면 탐험은 종료된다.

Return

예를 들어, [그림 1]의 예시에서

State-value function

직관적으로,

모든 state에 대한

예를 들어, [그림 1]에 표현된 Markov reward process의 각 state에 대한 state-value function은 [식 7]을 통해 아래의 [그림 2]와 같이 계산된다.

그러나 [식 7]과 같이 state-value function을 계산하는 방법은

MDP는 Markov reward process에 action이라는 요소가 추가된 모델로써, <

우리의 목적은 MDP로 정의된 문제에 대해 각 state마다 전체적인 reward를 최대화하는 action이 무엇인지를 결정하는 것이다. 이때 각각의 state마다 action의 분포 (action이 선택될 확률)를 표현하는 함수를 policy

MDP가 주어진

또한,

MDP에서 state-value function

Action-value function

State-value function은 어떠한 state가 더 많은 reward를 얻을 수 있는지를 알려준다면, action-value function은 어떠한 state에서 어떠한 action을 취해야 더 많은 reward를 얻을 수 있는지 알려준다. 만약 우리가 모든 state에 대해 action-value function을 계산할 수 있다면, 우리는 모든 state에 대해 optimal action을 선택할 수 있게 되는 것이다.

Optimal state-value function

비슷하게 optimal action-value function

'지능형시스템 > 머신러닝' 카테고리의 다른 글

| [머신 러닝/딥 러닝] 인공신경망 (Artificial Neural Network, ANN)과 역전파 알고리즘 (Backpropagation Algorithm) (11) | 2018.04.21 |

|---|---|

| [머신 러닝] 은닉 마르코프 모델 (Hidden Markov Model, HMM)의 개념과 학습 알고리즘 (0) | 2018.04.16 |

| [머신 러닝] 나이브 베이즈 분류기 (Naive Bayes Classifier, NBC) (0) | 2018.04.10 |

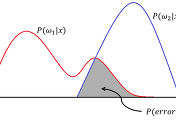

| [머신 러닝] Bayesian Decision Theory (0) | 2018.04.08 |

| [머신 러닝] 중요도 샘플링 (Importance Sampling)과 기댓값 추정 (4) | 2018.04.08 |